Un Week-end du Nouvel An sous le Signe de l’Innovation

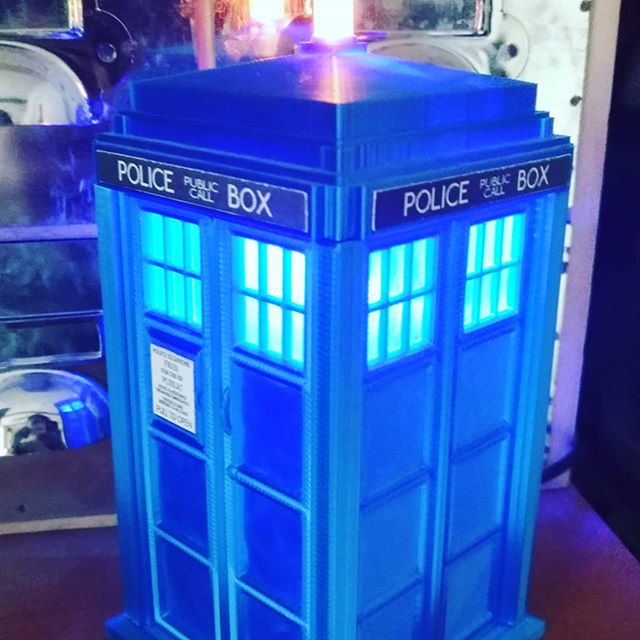

Alors que le monde célébrait l’arrivée de la nouvelle année, je me suis lancé dans un projet passionnant, motivé par l’envie de repousser les limites de l’impression 3D, je me suis payé une imprimante résine. Armé de ma toute nouvelle imprimante #Elegoo Saturn 3 Ultra, un cadeau de Noël à moi-même, j’étais prêt à explorer les possibilités offertes par cette technologie fascinante.

Le Dilemme des Slicers

Au cœur de l’impression 3D se trouve le slicer, un logiciel indispensable pour préparer les modèles pour l’impression. J’ai commencé par faire l’expérience des slicers fournit comme Chitubox et Voxeldance Tango. Cependant, je me suis heurté à des limitations avec la version gratuite de Chitubox, et des problèmes de licence avec Voxeldance Tango.

Dans ma quête de solutions, je me suis tourné vers Lychee Slicer, dont j’avais beaucoup entendu parler. Malgré son prix, j’ai été conquis par ses fonctionnalités (entre autre la détection d’effet ventouse) et j’ai fini par acquérir une licence. Lychee Slicer était un plaisir à utiliser, mais il manquait une fonctionnalité cruciale pour moi : la possibilité d’envoyer directement des fichiers à mon imprimante en WiFi.

De la Frustration à la Création

La procédure pour envoyer mes fichiers était fastidieuse : préparer le modèle dans Lychee Slicer, puis le réimporter dans Chitubox uniquement pour l’envoi en WiFi, une opération qui prenait un temps considérable. Cette routine frustrante m’a rapidement poussé à chercher une solution plus pratique.

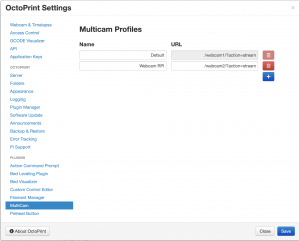

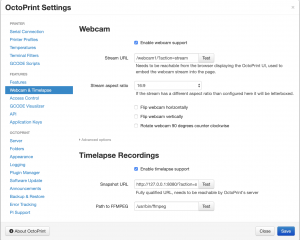

C’est alors que je suis tombé sur le projet Cassini, qui offrait la possibilité d’envoyer des fichiers à l’imprimante en ligne de commande. Si Cassini apportait une réponse à mon problème, l’absence d’une interface utilisateur graphique me laissait sur ma faim. Habitué à la convivialité d’OctoPrint pour mon imprimante à filament, je désirais quelque chose de similaire pour mon imprimante à résine.

La Naissance de Resin Print Portal

C’est ainsi qu’est né Resin Print Portal (RPP). Inspiré par Cassini, j’ai développé une interface web pour gérer mon imprimante résine, un outil qui allie la simplicité d’utilisation à l’efficacité, en voici un aperçu :

RPP est conçu pour rendre l’impression 3D à base de résine aussi pratique et agréable que possible, en permettant l’envoi de fichiers, le lancement et le suivi des impressions, le tout via une interface web conviviale.

L’Esprit d’Initiative d’un Non-Développeur

Il est important de mentionner que je ne suis pas un développeur de formation. Mon parcours dans la création de RPP est simplement celui d’un geek, motivé par le désir de surmonter un défi pratique plutôt que par une expertise en programmation. Ce projet est le fruit d’un apprentissage autodidacte, de l’exploration, la détermination et aussi un bon coup de main de ChatGPT. J’ai rassemblé des connaissances ici et là, apprenant sur le tas pour transformer mon idée en réalité.

C’est peut-être cette perspective de non-développeur qui rend RPP si intuitif et centré sur l’utilisateur. Mon objectif n’était pas de créer un outil complexe avec des fonctionnalités avancées, mais plutôt quelque chose de simple, efficace et, surtout, totalement fonctionnel. Dans le monde de la technologie, où l’on peut facilement se perdre dans les détails techniques, rappelons-nous que l’utilité et la fonctionnalité sont souvent ce qui compte le plus.

Resin Print Portal est la preuve qu’avec un peu de persévérance et beaucoup d’enthousiasme, les barrières de la complexité peuvent être franchies, même par ceux qui ne sont pas des professionnels du domaine.

Vers un Avenir Plus Lumineux en 3D

Alors que les feux d’artifice du Nouvel An illuminaient le ciel, Resin Print Portal est devenu mon feu de joie personnel. Ce projet est un exemple parfait de la manière dont une frustration peut se transformer en une opportunité de créer quelque chose de nouveau et d’utile, pas seulement pour moi, mais pour toute la communauté des passionnés d’impression 3D.

Si vous souhaitez en savoir plus sur ce projet ou y contribuer, je vous invite à visiter le projet sur GitHub.